Python爬虫游全国:青岛站

本文是全国城市旅游的第8站:从厦门、长沙、西安、大连、苏州、成都、兰州,到达了青岛。全文通过爬虫的方式从网上获取到两份数据:关于青岛的美食和景点的数据,并且进行数据处理、可视化和统计分析。

青岛

来自维基百科关于青岛的简介,大家可以了解这个海滨城市:

青岛市,简称青,旧称胶澳,别称胶、琴岛、岛城,是中华人民共和国山东省下辖的地级市,也是中国的副省级市、计划单列市和区域中心城市,中国沿海重要中心城市和滨海度假旅游城市、国际性港口城市、国家历史文化名城,山东半岛城市群和青岛都市圈中心城市,青岛经济发达,在北方城市中,经济总量仅次于京津2个直辖市

数据采集

关于景点数据的爬取:

关于美食数据的爬取:

具体的爬虫方法和过程在之前的文章中有介绍,可以参考。

青岛景点

导入库

导入相关的库:

1 | import pandas as pd |

数据基本信息

数据探索

In [3]:

1 | df1.shape |

Out[3]:

1 | (1664, 8) |

In [4]:

1 | df1.isnull().sum() |

Out[4]:

1 | cn_title 0 |

在景点的英文名en_title和简介abstract中存在缺失值

In [5]:

1 | df1.dtypes |

Out[5]:

1 | cn_title object |

景点位置分布

1 | c = ( |

攻略数排名

1 | c = ( |

评论数comment前10

驴友占比

1 | c = ( |

景点简介词云图

1 | title_abstract = df1["cn_title"].tolist() + df1["abstract"].tolist() |

前100个高频词语:

青岛美食

数据基本信息

基本信息

In [3]:

1 |

|

Out[3]:

1 | 中文名 0 |

In [4]:

1 |

|

Out[4]:

1 | 中文名 object |

得分排名

分析哪些店的得分靠前

得分处理

In [5]:

1 | # 得分中有未评分的数据:-- |

1 | df["得分"] = df["得分"].astype(float) |

店铺得分

1 | c = ( |

高分店铺top10

1 | c = ( |

均价处理

依据不同价格的分类:

1 | def price(x): |

1 | c = ( |

高档消费餐厅

1 | c = ( |

推荐菜

绘制推荐菜的词云图:

1 | result = df["推荐菜"].tolist() |

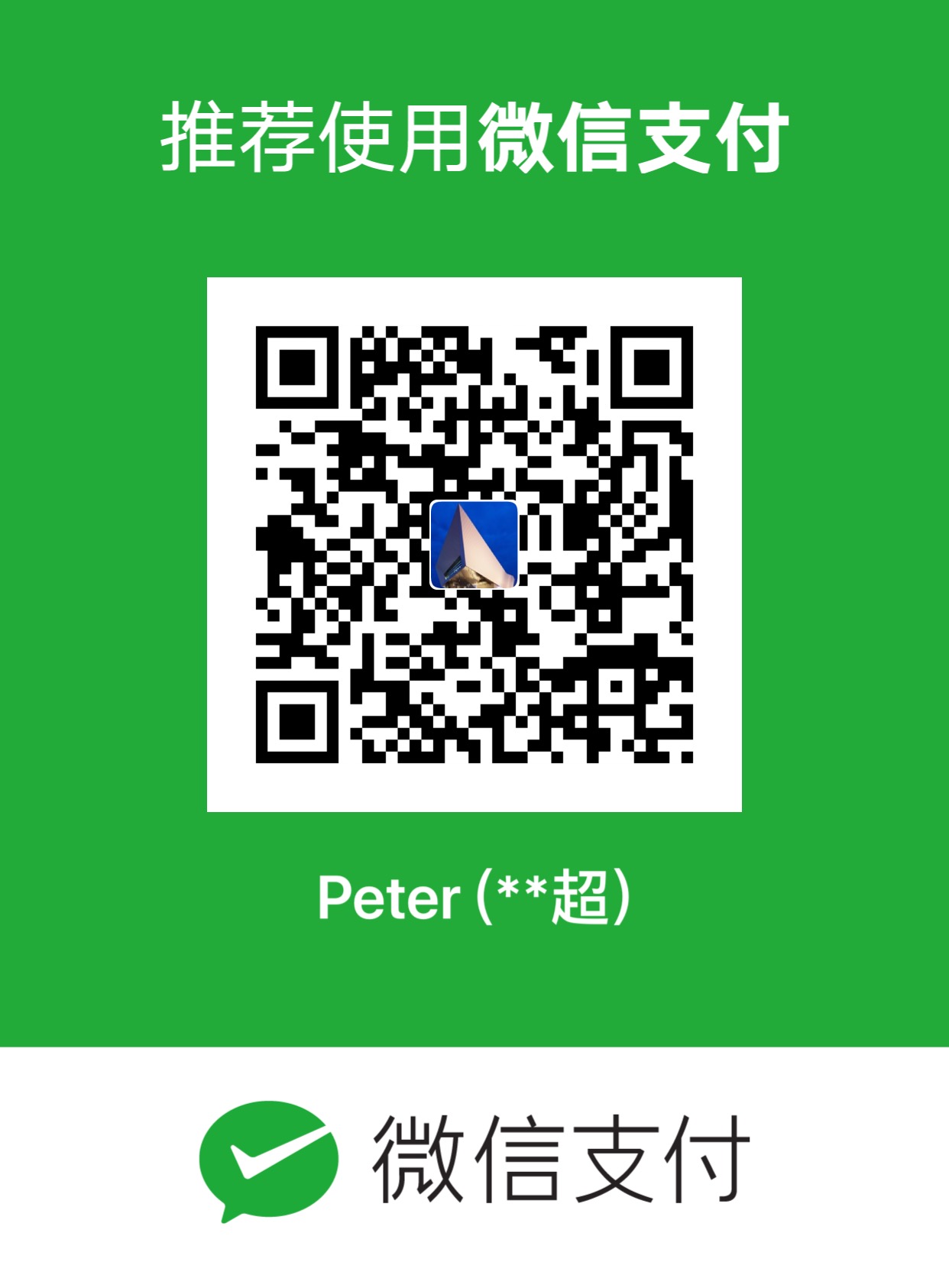

数据获取

完整的数据分析代码和数据,联系小编可获取,备注【公司/学校 + 姓名】可以获取~